Torben Lindø und Horst Warncke über das Oticon More und die Vorzüge der DNN-Technologie

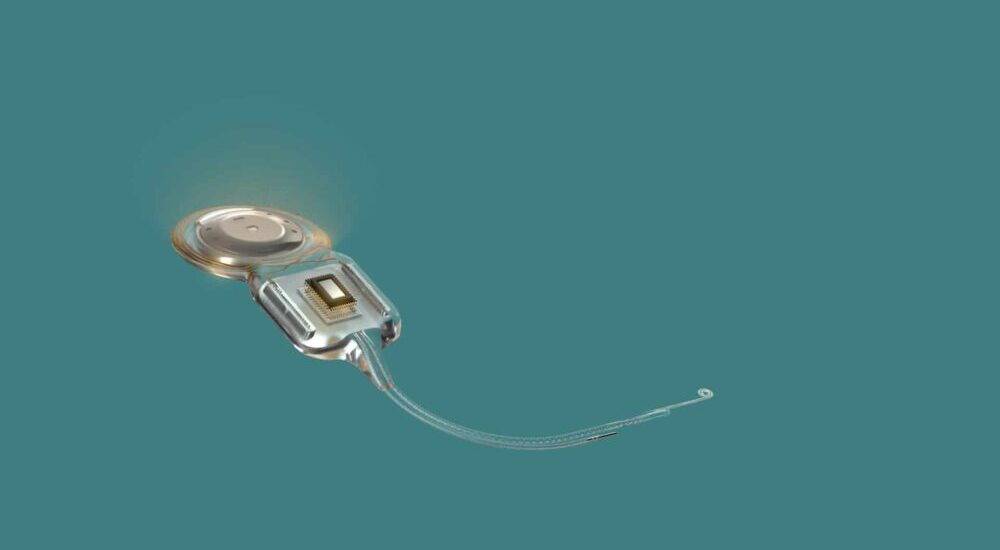

Mit dem Launch von More will Oticon erneut einen großen Sprung nach vorne machen. Dafür setzt der Hersteller in der Signalverarbeitung eine neue Technologie ein, die ohne vorher festgelegte Parameter in Echtzeit auf sämtliche akustische Situationen reagieren kann –

und dabei auf hörbare Kompression verzichtet. Darüber sowie über weitere Vorzüge von Oticon More sprachen wir mit Torben Lindø und Horst Warncke.

Eine Woche nach der Premieren-Show zum Oticon More gibt es die Gelegenheit für ein Interview bei Oticon in Hamburg. Für die Show habe man bewusst mehr auf unterhaltsames Edutainment gesetzt, denn auf die Präsentation sämtlicher Fakten, erzählt Marketingleiterin Sonja D’Introno vorab. Sozusagen als Kontrast zu all den Online-Schulungen, die seit Beginn der Pandemie von allen angeboten werden. Im Nachgang bietet der Hersteller unterschiedliche Schulungen an: Ob live und digital aus dem neu gebauten Filmstudio in Hamburg oder offline direkt beim Kunden. Und so zeigte Oticon am 30. November eine kurzweilige Show, die das Kampagnenbild zu den neuen Hörsystemen widerspiegelte. Denn ob im Garten, zwischen den Haustieren oder am Grill – im Leben ändern sich die akustischen Situationen permanent. Und dieser Herausforderung begegnet Oticon nun mit einem Deep Neural Network (DNN). Was das bedeutet, war denn auch das zentrale Gesprächsthema.

Herr Lindø, Herr Warncke, Sie bewerben Oticon More als das weltweit erste Hörsystem, das mit einem Deep Neural Network arbeitet. Zu unserem Verständnis: Was ist ein DNN? Und was macht es?

Warncke: Ein DNN ist zurzeit die höchste Form der künstlichen Intelligenz, die es gibt. Sie wird zum Beispiel für autonom fahrende Autos oder für autonom fliegende Raumsonden genutzt, letztere entscheiden beispielsweise, wann sie Gesteinsproben sammeln. Auch Alexa oder Siri nutzen diese Technologie. Der Unterschied zu den More Geräten besteht darin, dass die anderen Geräte große Batterien sowie sehr viel Platz für Rechner bieten, oder dass sie über eine Cloud mit riesigen Rechenzentren verbunden sind. Die More Geräte hingegen arbeiten in Echtzeit mit geringster Stromaufnahme und ohne Internetanbindung. Sie können akustische Situationen alle zwei Millisekunden neu bewerten. Das Spannende ist: Alle Algorithmen, die wir bisher in Hörgeräten verwendeten, waren auf physikalischer Basis. Das heißt, dass man zum Beispiel über die Modulation erkannt hat, ob ein Sprecher zu hören ist oder nicht. Was wir über die physikalischen Parameter aber nicht erkennen konnten war, ob die Klangwelt angenehm ist. Das DNN ist nun so trainiert worden, dass es nicht nur Sprache als ganz wichtiges Signal erkennt, sondern dass es auch die Natürlichkeit und das Angenehme von Klängen unterstützt.

Und was genau ist nun ein DNN? Uwe Andreas Hermann, der Leiter Ihres Forschungszentrums in Eriksholm, hat auf einem Oticon Symposium vor einigen Jahren erklärt, dass DNN im Grunde die Arbeitsweise des menschlichen Gehirns nachahmen …

Warncke: Genau. Wir haben Milliarden von Neuronen in unserem Gehirn – kleine „Rechenzellen“, die miteinander in Verbindung treten, um zum Beispiel zu erkennen, ob da jemand spricht und ob im Hintergrund Geräusche sind, so dass wir uns auf den gewünschten Sprecher konzentrieren können. Diese Fähigkeit bilden wir technisch nach. Unser DNN arbeitet am Eingang, wo die Mikrofonsignale aufgenommen werden, mit 24 Neuronen – und damit abgestimmt auf die 24 Kanäle in der Eingangsstufe. Diese Neuronen sind mit sogenannten versteckten Schichten („Hidden Layer“) mit weiteren Neuronen verbunden, die wiederum zu Output-Layer führen, von wo aus das Signal in den Lautsprecher geht. Entscheidend ist dabei, was zwischen den Eingangs- und Ausgangsneuronen passiert. Und das ist angelehnt an die natürlichen Prozesse in unserem Gehirn. So wurde unser DNN zum Beispiel im Training von echten Menschen bewertet. Hat das Testsystem Stimmen nicht gut genug erkannt und hervorgehoben, musste es noch mal üben, bis die Erkennung funktionierte. Anschließend konnte das Training automatisiert werden. So können eine Unzahl von menschlichen Stimmen in einer Sounddatenbank abgelegt werden, um diese dann automatisiert durch das DNN bewerten zu lassen. Da bekannt war, in welchen Soundbeispielen Stimmen enthalten waren, kann auch die qualitative Bewertung der DNN-Entscheidung automatisch erfolgen. In diesem Zusammenhang wird gerne gefragt, ob „nur“ 12 Millionen Szenen erkannt werden können. Nein, das ist nur die Zahl der Trainingseinheiten, danach kann More unendlich viele Klänge verarbeiten. Man kann das vielleicht mit einem Kind, das Laufen lernt, vergleichen. Es übt zu Hause, bis es Laufen kann. Hat es das einmal gelernt, kann es jeden Weg auf dieser Welt laufen und nicht nur den, den es geübt hat. Genau so kann unser neuronales Netzwerk nach dem Training alle Klänge verarbeiten und nicht nur die, die vorher in einem Algorithmus festgelegt wurden.

Und so ein DNN steckt nun in jedem Oticon More Hörsystem?

Lindø:Ja, und es arbeitet, wie gesagt, ohne Cloud-Anbindung oder andere Internet- oder Smartphone-Verbindung.

Warncke: Wir arbeiten seit 2004 mit künstlicher Intelligenz. Das Syncro war unser erstes Gerät mit künstlicher Intelligenz, seitdem ist das in unseren Geräten Standard. Ein Beispiel: Wir sprechen von 12 Millionen Klangszenen, mit denen wir das System trainiert haben – für eine Anwendung von unendlich vielen Szenen. Andere machen damit Werbung, dass sie sieben Klangwelten erkennen können. Wieder andere schreiben, sie bräuchten zehn Sekunden, um von einer in die andere Situation umschalten zu können. Wir brauchen zwei Millisekunden. Wenn Sie also fragen, was ein DNN möglich macht: Es ermöglicht eine völlig natürliche Klangwiedergabe in Echtzeit. Das ist der Vorteil, den die Nutzer erleben werden und den die Akustiker ihren Kunden als großen Mehrwert anbieten.

Wie können wir uns das Training mit 12 Millionen Klang-Szenen eigentlich vorstellen? Sie hatten eben davon gesprochen, dass man das Training nach einer gewissen, nennen wir es Aufwärmphase, automatisierte …

Warncke: Alle bisherigen Ansätze gingen davon aus, dass man die akustische Welt in Schubladen stecken kann. Das glauben wir nicht. Es gibt unendlich viele Situationen, die alle miteinander vermischt sind. Permanent passiert alles Mögliche: alles ändert sich unerwartet, nichts ist statisch, außer in Laborsituationen. Und dort wurden bisher in Geräten viele Algorithmen entwickelt. Was das Training angeht, lief das bei More anfangs so, dass mit einem sphärischen Mikrofon sehr viele reale Sounds aufgenommen wurden. Menschen, die selbst Hörsysteme tragen, haben danach bewertet, ob es etwas besser oder schlechter klang. Mit 12 Millionen Szenen kann man das natürlich nicht machen, das würde viel zu lange dauern. Also hat man es dann automatisiert. Nach einer gewissen Zeit lässt man das System dann wieder raus, um erneut mit echten Menschen zu trainieren und zu schauen, ob die einen Vorteil erleben. Und je nachdem, wie die Bewertungen ausfallen, wird weiter trainiert, bis wir schließlich damit rausgehen können. Und das war nach 12 Millionen Klängen, es hätten genauso auch 11 oder 13 Millionen Klänge sein können.

Könnte man, nach dem, was Sie sagen, das Wirken des DNN mit dem einer Automatik vergleichen, nach dem Motto, dass Oticon nun die Super-Automatik hat?

Warncke: Man könnte es eine „Super-Automatik“ nennen, mit dem Unterschied, dass sie keine festen Parameter hat, sondern in Echtzeit auf alles reagieren kann, was da ist. Wir hängen also nicht mehr von Algorithmen ab, die vorab entwickelt wurden. Ein Beispiel hierzu: Als das System entwickelt wurde, dachte noch niemand an Corona und das Tragen von Masken. Doch durch das DNN hat Oticon More auch einen Maskenmodus. Das System wurde ja darauf trainiert, Stimmen zu erkennen und so anzuheben, dass man sie besonders gut und klar verstehen kann. Es erkennt also auch die durch die Maske gedämpfte Stimme und hebt sie an, ohne dass das vorher bedacht wurde. Gleichzeitig wurde aber auch darauf geachtet, dass Klänge wie Musik oder Vogelgezwitscher angenehm klingen.

Bei der Premieren-Show sprachen Sie davon, dass Nutzern mit Oticon More nun die ganze Perspektive eröffnet werde. Hatten Sie das nicht im Zuge des Starts von Oticon Opn auch schon gesagt? Ist es jetzt einfach noch eine Schippe mehr?

Lindø: Wir haben einen klaren Weg, was unsere audiologische Richtung angeht, und der heißt BrainHearing. Das meint, dass wir mit unseren Ohren hören und mit unserem Gehirn verstehen. Daher arbeitet unser Forschungszentrum auch mit anderen Forschungszentren weltweit zusammen, mit Forschern, mit Neurologen. Was wir nun erleben, ist auch ein Ergebnis dieser Zusammenarbeit. Unsere ersten Schritte haben wir mit den Opn Geräten gemacht, mit More gehen wir nun ein paar Schritte weiter. Unterm Strich bedeutet es, dass das, was das Gehirn serviert bekommt, deutlich mehr und auch viel präziser ist. Und es geht nicht mehr nur darum, wieviel Verstärkung oder Kompression man dazugibt, sondern auch darum, was angenehm ist. Und es geht darum, dass das, was im Gehirn ankommt, auch so ist, wie es das Gehirn erwartet. Im Ergebnis wird deutlich weniger Höranstrengung und deutlich mehr natürliches Hören erreicht.

Sie sprechen in diesem Zusammenhang auch von dem neuronalen Code, der vom Ohr aus ans Gehirn gesendet wird, und der nun noch vollständiger ist und so die Arbeit der für das Hören zuständigen Subsysteme erleichtere. Wie kommen Sie darauf?

Warncke: Unabhängige Universitäten in Maryland oder in New York sind da zu den gleichen Ergebnissen gekommen wie wir in unserem Forschungszentrum Eriksholm. Nämlich, dass das Gehirn möglichst viele Informationen braucht, um sich orientieren und fokussieren zu können. Diese Erkenntnis hat sich im vergangenen und in diesem Jahr erst verfestigt. Wir ahnten schon, dass es so sein würde und forschten deshalb in diese Richtung. Dank objektiver Methoden wie EEG-Messungen wissen wir es nun. Und mit unseren More Geräten können wir im Vergleich zu den Opn S Geräten noch mal bis zu 30 Prozent drauflegen. Gegenüber dem ausgeschaltetem DNN wird die Orientierung nachweislich sogar um 60 Prozent besser. Durch die DNN-Technik können wir also nicht nur eine Schippe drauflegen, sondern einen ganzen Muldenkipper.

Wird damit die Neurologie zu einem weiteren großen Thema für Oticon?

Lindø: Gerade, weil das Verstehen in unserem Gehirn stattfindet, müssen wir uns auch mit diesem Thema beschäftigten. Das heißt aber nicht, dass man in Zukunft Mediziner sein muss, um Hörsysteme anpassen zu können. Wir haben das in unsere Signalverarbeitung eingebaut. Für die Akustiker geht es also weiter um eine gute Beratung und die individuelle Anpassung.

Damit kommen wir zu der großen Frage, wie Hörakustikerinnen und -akustiker damit nun mit ihren Kunden arbeiten können. Was bedeutet all das für die Arbeit in den Fachbetrieben?

Warncke: Zunächst sind wir dem Wunsch vieler Akustiker nachgekommen, mehr Einfluss auf die Automatiken zu bekommen. So hat man nun, auch im Vergleich zu den Opn Geräten, noch mal mehr Einflussmöglichkeiten. Man kann in Genie außerdem vorbestimmen, wann die MoreSound Intelligence intensiv zu arbeiten beginnt – je nachdem, in welchen Situationen ein Kunde Schwierigkeiten hat. Zudem kann man für einfache sowie komplexe Situationen den Grad der Unterstützung einstellen. Darüber hinaus kann man ein virtuelles Außenohr programmieren. In drei Stufen kann so die Funktion unseres Außenohres, der Pinna-Effekt, eingestellt werden. Dazu kommt der Sound Enhancer, über den man für akustisch schwierige Situationen noch mal eine extra Sprach-Unterstützung in drei Stufen einstellen kann. Statt wie bisher 16 haben wir nun 24 Kanäle, die je in vier Ebenen eingestellt werden können. Das ist mehr als je zuvor!

Lindø: Man kann sagen: Mit unserer neuen Signalverarbeitung sorgen wir dafür, dass wir ein System haben, was bestmöglich das normale Hören simuliert und was deutlich besser ist als alles bisher Dagewesene. Nun ist die Aufgabe der Akustiker, diese Anpassung zu individualisieren. Und das kann man mit unserer aktualisierten, noch flexibleren Software tun. Gleichzeitig haben wir aber vieles, was sich bewährt hat, beibehalten. So kann man die gleichen Hörer verwenden wie bei den Opn Geräten. Und auch der Akku lässt sich weiterhin bei Bedarf austauschen.

Warncke: Außerdem glauben wir, dass der First Fit noch besser geworden ist.

Sie sprachen eben bereits von MoreSound Intelligence. Was ist das? Wie lässt sich das nutzen?

Warncke: MoreSound Intelligence ist das Gehirn der Geräte, darin ist das DNN verankert. Dahinter kommt dann der MoreSound Amplifier, den Akustiker in fünf Bereichen modifizieren können. Man hat hier Möglichkeiten, den Einfluss der Hörumgebung zu regeln, das virtuelle Außenohr, den Sound Enhancer sowie die einfache und die komplexe Umgebung. Wir denken, dass sich für viele Akustiker und deren Kunden ganz neue Welten auftun werden.

Außerdem sprachen Sie davon, keine hörbare Kompression mehr zu nutzen. Warum?

Warncke: Mit unserer neuen Polaris Plattform haben wir jetzt doppelt so viel Arbeitsspeicher wie in dem Velox S Chip, acht mal mehr Rechenleistung, so dass wir nun die 16-fache Kapazität im Vergleich zum Velox S Chip haben. Dadurch haben wir speziell im Hauptsprachbereich eine doppelt so hohe Auflösung. Geht es um einzelne Sounds, ist die Auflösung sechs Mal größer. Uns geht es dabei vor allem um die Geschwindigkeit. Wie gesagt können wir alle zwei Millisekunden auf Sounds reagieren. Und das nutzen wir dafür, auf hörbare Kompression zu verzichten. Durch die hohe Geschwindigkeit können wir zwischen verschiedenen Verstärkungszuständen hin und her springen. Knallt eine Tür zu, arbeiten wir zum Beispiel mit einem Zustand sehr geringer Verstärkung, bei Sprache springen wir in einen Zustand mittlerer Verstärkung und bei Musik springen wir wieder in einen anderen Zustand der Verstärkung. Dabei wird alles linear verstärkt, ohne hörbare Kompression.

In puncto Konnektivität bieten Sie An-droid-Usern nun, sofern das entsprechende Smartphone das ASHA Protokoll unterstützt, die gleiche Konnektivität wie Apple-Nutzern?

Lindø: Richtig. Besonders wichtig ist uns hier Bluetooth Low Energy, denn wir möchten bei der audiologischen Performance keine Kompromisse machen. Das hat etwas gedauert, aber nun haben wir diese Konnektivität, ohne dafür Kompromisse machen zu müssen.

Warncke: Viele wünschten sich für das Streaming außerdem einen Equalizer. Für Tinnitus hatten wir den schon, nun haben wir den Equalizer auch für alle Streaming-Sounds.

Außerdem neu ist der OpenBass Schirm. Was macht der?

Warncke: Wir sagen bekanntlich, dass man möglichst offen anpassen soll, damit die natürliche Klangwelt erhalten bleibt. Wenn jemand einen Hochton-Steilabfall hat, hört der die tiefen Frequenzen ja noch relativ normal. Warum also soll man dieses Ohr verschließen? Andererseits kam aber die Diskussion auf, dass speziell beim Streamen Musik zu wenig Bassanteil habe. Der neue OpenBass Schirm hat nun mehrere Funktionen gleichzeitig. Zum einen hat er eine Vent-Wirkung von 4,5 bis 5 Millimeter. Zudem hat er patentierte Sound-Kanäle, die dieses offene Gefühl erzeugen, aber gegenüber Rückkopplungen gleichzeitig eine um etwa 9 dB größere Sicherheit bieten. Außerdem werden die gestreamten Klänge um bis zu 6 dB lauter übertragen, was gerade im Bassbereich eine zusätzliche Unterstützung bedeutet.

Also sagen Sie, dass der OpenBass Schirm eine Alternative zur Otoplastik ist?

Warncke: Wir empfehlen nach wie vor Otoplastiken als erste Wahl, einfach, weil sie individuell sind, einen besseren Halt am Ohr bieten und insgesamt eben auch eine definierte Akustik ermöglichen. Aber für beispielsweise Tage der offenen Tür oder Gesundheitsmessen ist der OpenBass Schirm ideal.

Welche Erwartungen haben Sie an den Launch der More-Geräte? Ähnliche wie an den Start von Oticon Opn?

Lindø: Opn war 2016 für uns eine positive Überraschung. Es kommen bei Oticon regelmäßig neue Produkte, und jedes Mal wird es besser. Mit Opn war es anders, da haben wir einen Sprung nach vorne gemacht, die Geräte haben sich ja schon beinahe als Marke etabliert. Und nun sind wir überzeugt, dass More genauso eine Wirkung haben wird. More basiert wieder auf der BrainHearing-Philosophie, aber durch das Deep Neural Network haben wir jetzt die Möglichkeit für eine komplett neue Signalverarbeitung bekommen. In den Tests berichteten die Probanden von einer signifikanten Verbesserung im Vergleich zu den Opn S Geräten. Und nun freuen wir uns, More den Akustikern anbieten zu können, die wiederum ihren Kunden die ganze Perspektive eröffnen.

Herr Lindø, Herr Warncke, haben Sie vielen Dank für das Gespräch.

Einloggen

Einloggen